"کف کوانتومی" هدف یک آزمایش ساده

یک محقق آزمایش سادهای را پیشنهاد داده است که با استفاده از آن میتوان اثرات گرانش کوانتومی از جمله "کف کوانتومی" را که تنها در مقیاسهای طولی بسیار کوچک از مرتبه طول پلانک خودشان را نشان میدهند مورد بررسی و مشاهده قرار داد.

آنطور که یاکوب بکنشتاین میگوید، میتوان یکی از بزرگترین چالشهای فیزیک امروز (یافتن شواهدی برای گرانش کوانتومی) را به کمک یک آزمایش رومیزی ساده از پیش رو برداشت. بکنشتاین که به دلیل مطالعاتش بر روی ترمودینامیک سیاهچالهها به خوبی شناخته شده است، به تازگی پیشنهادی را مبنی بر بررسی اثرات «کف کوانتومی» با استفاده از فوتونهای منفرد مطرح نموده است. کف کوانتومی که نخستین بار در سال 1955 توسط فیزیکدان آمریکایی جان ویلر (John Wheeler) معرفی شد، اثری است که در مقیاسهای بسیار کوچک یعنی در شرایطی که افت و خیزهای کوانتومی ساختار فضا-زمان را تحت تاثیر قرار میدهند، ظاهر میشود.

پیشنهاد بکنشتاین در واقع جدیدترین تلاش برای درک چگونگی اتحاد مکانیک کوانتومی و نظریه نسبیت عام اینشتین به شمار میرود. مسئلهای که فیزیکدانان را از اوایل قرن بیستم درگیر نموده است، یعنی زمانی که شروع به دیدن جهان از دو دریچه مکانیک کوانتومی و نسبیت عام کردند. یکی از دلایلی که باعث نزاع میان فیزیکدانان در رابطه با نظریات گرانش کوانتومی شده است کمبود شواهد تجربی است. در واقع مشکل اصلی این است که انتظار میرود اثرات گرانش کوانتومی تنها در مقیاسهای طولی بینهایت کوچک قابل مشاهده و اندازهگیری باشند. برخی از نظریات گرانش کوانتومی پیشنهاد میکنند که آزمایشها باید شامل کاوش در ابعاد طولی کوچکتر از طول پلانک باشند که برابر با 1.6×10-35متر است. اگر بخواهیم این مقیاس را با استفاده از یک شتابدهنده ذرات مورد کاوش قرار دهیم، باید شرایطی را فراهم کنیم که در آن ذراتی با انرژی بسیار زیاد از مرتبه 1016 ترا الکترون ولت به هم برخورد کنند. این امر بسیار فراتر از حد توان شتابدهنده هادرونی بزرگ (LHC) با بیشینه انرژی 14 ترا الکترون ولت و در واقع فراتر از حد توان هر شتابدهنده دیگری در آینده نزدیک است. با این حال پیشنهاد بکنشتاین بسیار ساده است و آنطور که او ادعا میکند، میتوان آن را در یک آزمایشگاه کوچک فیزیک و با کمک تجهیزاتی که امروزه در اختیار داریم نیز انجام داد.

آمادهسازی فوتونها

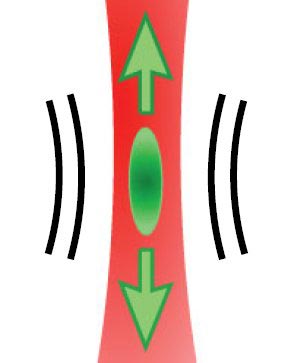

آزمایش پیشنهادی بکنشتاین، شامل شلیک فوتونهای منفرد به سمت یک تکه شیشه یا بلور است که از نخ نازکی آویزان شده است. هنگامی که فوتون از خلا وارد ماده میشود سرعتش به دلیل بالاتر بودن ضریب شکست ماده نسبت به ضریب شکست خلا کاهش مییابد. در نتیجه این امر، مقدار اندکی از تکانه فوتون به ماده منتقل میشود و باعث جابهجایی آن به اندازه بسیار کم میشود. بکنشتاین میگوید چنانچه از فوتونهای نور آبی با طول موج 445 نانومتر استفاده کنیم، به ازای برخورد هر فوتون به یک قطعه 150 گرمی از شیشه سربدار ( نوع ویژهای از شیشههای سیلیکاتی که در ترکیب خود حاوی اکسید سرب است) شیشه به اندازه 2×10-35 متر جابهجا میشود که تقریبا با طول پلانک برابر است. نکته اصلی آزمایش در این است که اگر یک فوتون در سمت دیگر شیشه آشکارسازی شود به معنای آن است که شیشه به اندازه بیشتر از طول پلانک جابهجا شده است. اما چنانچه انرژی فوتون به اندازهای کاهش پیدا کند یا به طور معادل جرم شیشه به اندازهای افزایش پیدا کند که جابهجایی آن کوچکتر یا مساوی طول پلانک شود، گرانش کوانتومی چگونگی پاسخ شیشه به هر فوتون را تحت تاثیر قرار خواهد داد.

بکنشتاین بر این باور است که حضور کف کوانتومی مانع از آن میشود که شیشه به همان صورتی که وقتی به طور متوالی با فوتونهای همسان مورد برخورد قرار میگیرد دچار پسزنی شود. در واقع همانطور که افت و خیزهای الکترومغناطیسی میتواند اثرات قابل اندازگیری بر اجسام بزرگتر داشته باشد – یک مثال خوب در این رابطه نیروی کازیمیر است- افت و خیزهای فضا-زمانی نیز باید چگونگی حرکت یک جسم در فواصل بسیار کوچک را تحت تاثیر قرار دهند. در مورد آزمایش پیشنهادی بکنشتاین، فوتونها قادر به حرکت در داخل شیشه نیستند که این موضوع به صورت افت در تعداد فوتونهای آشکارسازی شده در سمت دیگر شیشه مشاهده میشود.

بکنشتاین تصدیق میکند که این آزمایش "بسیار چالش برانگیز است، اما فراتر از توان فیزیکدانان تجربی امروز نیست". در حقیقت خلق و آشکارسازی فوتونهای منفرد، امروزه یک امر کاملا عادی در آزمایشهای اپتیک کوانتومی محسوب میشود که در آزمایشگاههای بسیاری در سراسر دنیا در حال انجام هستند. کمینه کردن اثرات نوفه حرارتی نیز یکی از چالشهای پیش روی این آزمایش است و آنطور که محاسبات بکنشتاین نشان میدهد، دستگاه باید تا دمای 1 کلوین سرد شود و در شرایط خلا کامل با فشار 10-10 پاسکال قرار گیرد که هر دوی این شرایط فناوریهای بسیار پیشرفتهای را میطلبند.

سایر طرحهای رومیزی

بکنشتاین تنها فیزیکدانی نیست که آزمایشهای سادهای را برای کاوش در نظریه گرانش کوانتومی پیشنهاد داده است. به عنوان مثال، در اوایل سال جاری ایگور پیکوفسکی (Igor Pikovski) و همکارانش از دانشگاه وین و کالج سلطنتی لندن روشی را برای انجام اندازهگیریهای اپتیکی بر روی یک نوسانگر مکانیکی با جرمی در حدود جرم پلانک (حدود 22 میکرو مول) پیشنهاد دادند. در حقیقت پیکوفسکی به فیزیکز ورلد (physicsworld.com) گفته است که آزمایش بکنشتاین کاملا امکان پذیر به نظر میرسد. آنطور که وی اشاره میکند " یکی از مزایای آزمایش پیشنهادی بکنشتاین آن است که فیزیکدانان میتوانند فوتونهای منفرد را به خوبی کنترل کنند و به صورت کاملا دقیق آنها را آشکاریسازی نمایند."

پیکوفسکی همچنین تصریح میکند که تکنیک استفاده شده در آزمایش بکنشتاین بسیار سودمند است، حتی اگر برخی مسائل آزمایشگاهی به آن اجازه کاوش در فواصلی از مرتبه 10-35 متر را ندهد. دلیل این امر آن است که طبق پیشبینی برخی از نظریات گرانش کوانتومی اثراتی همچون کف کوانتومی میتوانند در مقیاسهای طولی به بزرگی 10-25 متر نیز خودشان را نشان دهند. اگرچه هنوز مشخص نیست که آیا آزمایشهای رومیزی پیشنهادی نظیر آزمایشهای بکنشتاین، پیکوفسکی و دیگران با موفقیت روبرو خواهند شد یا خیر، با این حال پیکوفسکی معتقد است که اندازهگیریهای آزمایشگاهی انجام گرفته توسط این آزمایشها اطلاعات بسیار مهمی را در رابطه با گرانش کوانتومی طی دهههای آینده فراهم خواهند کرد.